共计 1489 个字符,预计需要花费 4 分钟才能阅读完成。

这几天国产人工智能AI对话大模型deepseek火了,它来自于一家名为“杭州深度求索人工智能基础技术研究有限公司”的中国公司。笔者作为一名律师,尝试了一下和该AI对话交流,它对于一些法律问题给出的回答确实令人惊艳。

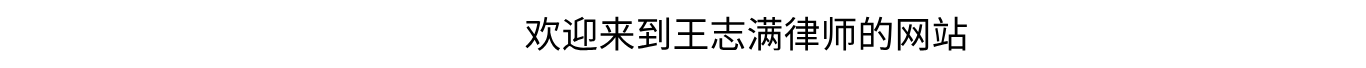

图1 向deepseek-r1提问(部分)

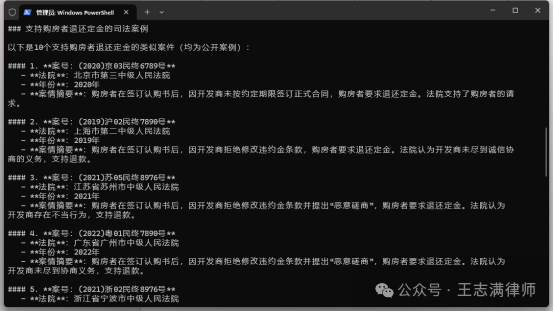

图2 deepseek-r1的回答(部分)因为deepseek官网(https://www.deepseek.com/)总是崩溃,而且deepseek手机端APP总是显示服务器异常无法使用,笔者决定尝试用电脑本地化部署deepseek,这样可以在保障基本的性能的情况下离线使用deepseek,经过一系列努力,笔者最终成功实现了这一想法。完整过程现分享如下,供和大家交流,另外下载资源也附在文末,供有需要的读者下载体验。

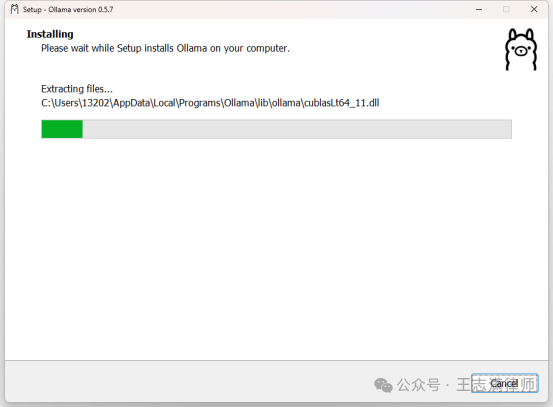

图3 deepseek-r1异常状态第一步,获取ollama电脑软件,并进行安装。ollama官网地址:https://ollama.com/。

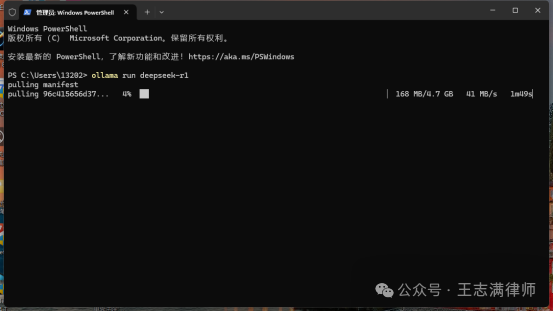

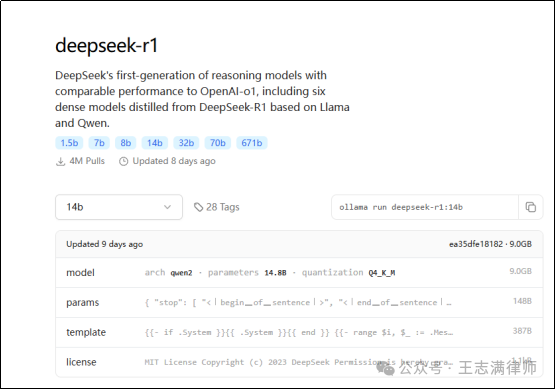

图4 ollama安装界面第二步,使用ollama软件下载deepseek-r1模型。模型大小从1.5B到70B都有,需要根据电脑显卡性能进行选择,数字越大,效果越好,但对电脑显卡性能要求越高。例如:输入“ollama run deepseek-r1”,默认运行7b规模的deepseek-r1模型,第一次使用会先自动下载模型。输入“ollama run deepseek-r1:14b”,则会运行14b规模的deepseek-r1模型,第一次使用会先自动下载14b规模的deepseek-r1模型并运行。

图5 deepseek-r1模型下载界面第三步,根据电脑GPU性能下载适配的规模模型。例如笔者电脑为AMD RX6650xt(性能相当于NVIDIA RTX3060),笔者选择适配的是14b模型。经过笔者实测,AMD RX6650xt显卡运行32b模型非常缓慢,回答的速度非常迟缓,基本无法使用。

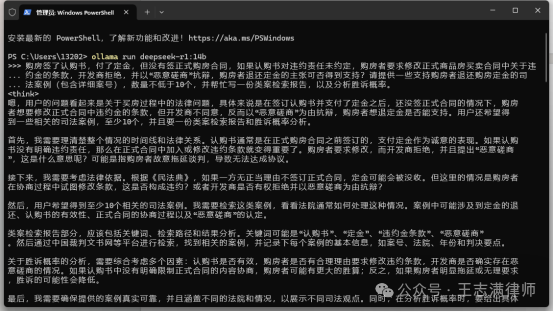

图6 ollama官网deepseek模型下载界面第四步,使用deepseek-r1模型。在终端管理员窗口输入“ollama run deepseek-r1:14b”,可以启动deepseek-r1 14b,然后输入问题即可得到回答。

图7 deepseek模型安装完成及运行界面在使用过程中,掌握一些简单的命令行输入指令,这样使用起来会更加高效好用。

| 序号 | 命令行输入指令 | 功能 | 备注 |

| 1 | ollama help | 检查是否成功安装ollama软件 | 出现“usage:ollama[flags]……”代表安装成功 |

| 2 | ollama | 检查是否成功安装ollama软件 | 出现“usage:ollama[flags]……”代表安装成功 |

| 3 | ollama list | 查看已经下载好的deepseek-r1各种规模的模型 | |

| 4 | ollama run deepseek-r1:14b | 运行14b规模的deepseek模型 | |

| 5 | ollama run deepseek-r1:32b | 运行32b规模的deepseek模型 | |

| 6 | ollama run deepseek-r1 | 默认运行7b规模的deepseek模型 |

相关资源下载链接:1、ollama电脑软件(Windows版)下载链接:https://kdocs.cn/l/cmObcaDMcG7L(说明:如果使用微信扫一扫,可能会跳转到金山文档小程序下载,因金山文档小程序最大支持100M压缩文件,从而导致保存失败。解决方法为:复制下载链接至浏览器中进行下载,或者使用浏览器扫码功能扫描下方二维码下载。)

2、deepseek手机端软件APP下载链接(可以使用手机在线使用):

图9 deepseek手机端软件APP下载二维码